안녕하세요 루리입니다 ;)

다들 주말 잘 보내셨나요?

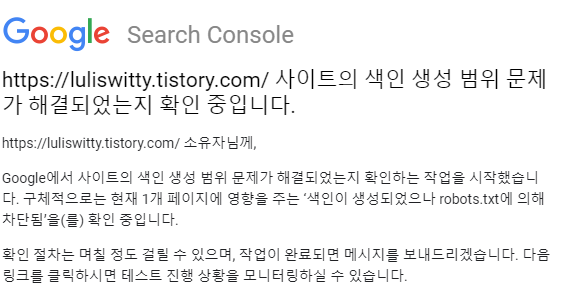

저는 잘 보내다가 갑자기 구글 서치 콘솔팀에서 메일을 받고 난 뒤 어리둥절한 상태랍니다😂

아래 사진과 같이 메일이 일요일 낮에 왔습니다.

확인 중이라고 하길래 '진행 상황 보기'를 눌렀습니다.

뭐가 접수됐다고 나오네요,,

그래서 구글 서치 콘솔의 메뉴 중에서 '색인 생성 범위'를 들어갔습니다!

여기를 들어가면 아래와 같은 화면이 나옵니다.

다행히 오류는 없다고 나오네요.

이게 불행중 다행인 걸까요ㅋㅋ큐ㅠㅠㅠ

저 노란 막대그래프 아래 숫자 1을 클릭하니까 다음과 같은 안내 문구가 나왔습니다.

"색인이 생성되었으나 robots.txt에 의해 차단됨"

당최 이게 무슨 소리인지 아무것도 몰라서 찾아봤습니다.😂

1. 크롤러

웹에서 페이지를 크롤링(가져오기)한 다음 색인을 생성하는 자동 소프트웨어

크롤러는 웹사이트를 방문한 다음 사이트에 있는 링크를 사용하여 다른 페이지를 찾습니다.

이 크롤러는 여러 링크를 넘나들며 이러한 웹페이지에 관한 데이터를 Google 서버로 가져옵니다.

☞ 이렇게 신규 또는 웹페이지를 찾는 프로세스를 '크롤링'이라고 합니다.

▼

크롤러가 웹페이지를 찾으면 Google 시스템에서는 브라우저와 마찬가지로 해당 페이지의 콘텐츠를 렌더링 합니다

2. 색인(Indexing)

특정 장소(문서)에 데이터를 저장하는 과정

Google에서는 알고 있는 모든 웹페이지를 색인에 저장합니다.

각 페이지의 색인 항목은 해당 페이지의 콘텐츠 및 위치(URL)를 명시합니다.

Google에서 페이지를 가져와서 읽고 색인에 추가하면 색인이 생성됩니다.

. Google 검색의 색인은 책 뒤에 있는 색인과 같아서,

Google에서 색인을 생성하는 모든 웹페이지에서 발견한 모든 단어에 관한 항목이 포함되어 있습니다.

웹페이지 색인이 생성되면 웹페이지에 포함된 모든 단어의 색인 항목에 웹페이지를 추가합니다.

3. robots.txt

인터넷 검색엔진 배제 표준(Robots Exclusion Protocol)이란 보안이 필요한 내용이 검색엔진에 유출되지 못하도록 웹 페이지를 작성하는 방법을 기술한 국제 기술 표준

콘텐츠 크롤링이 서버에 문제를 일으키는 경우 사용합니다.

예를 들어, 무한 캘린더 스크립트의 크롤링을 금지할 수 있습니다.

비공개 콘텐츠를 차단하거나(대신 서버 측 인증 사용) 표준화를 처리하는 데 robots.txt를 사용해서는 안 됩니다.

이렇게 용어 뜻을 알아보았는데 이해가 가시나요?!

설명이 더 필요하신 분들을 위해서 유튜브 링크 걸어 놓을 테니 보시면 도움이 될 것 같아요!

28분 23초부터 보시면 됩니다ㅎㅎ

www.youtube.com/watch?v=8Hs6HVyZPCE

< 해결방법 >

여러분 제가 어떤 페이지가 문제인지 맨 첫 번째 사진에 있는 링크를 눌러봤더니 제 관리자 페이지더라고요.

검색용 봇이 제 티스토리 관리 페이지는 노출시키지 않도록 제대로 작동하고 있다는 뜻이라고 합니다.

이 분 블로그 보니까 걱정 말고 열심히 포스팅하면 된대요ㅎㅎ..!

휴 왜 이렇게 용어가 어려운 건지,, 괜히 겁먹은 하루였어요😅

'색인이 생성되었으나 robots.txt에 의해 차단됨' 해결 방법

이런 이메일을 한통 받았습니다!! 아마도, 같은 내용의 메일을 받으신 분들이 이 게시물을 읽으실거라고 생각합니다. "사이트 https://loogigame.tistory.com/에서 새로운 적용 범위 문제가 발견됨" 이라

loogigame.tistory.com

우선 확인 절차가 며칠 걸릴 수 있다고 하고, 작업이 완료되면 알려준다니 일단 기다려보겠습니다.

결과 나오면 알려드릴게요!

혹시 이와 비슷한 경험이 있으신 분이 계시면 댓글 부탁드리겠습니다.🙏🏻🙏🏻🙏🏻

댓글